A recém-lançada demo pública do modelo de linguagem de inteligência artificial (IA) da Meta, controladora do Facebook, foi retirada do ar após cientistas e acadêmicos mostrarem que ele estava gerando uma grande quantidade de informações falsas e enganosas, incluindo citações de autores reais para trabalhos que não existiam, enquanto filtrava categorias inteiras de pesquisa.

Galactica (GAL) é descrita pela empresa como um modelo de linguagem de IA que “pode armazenar, combinar e raciocinar sobre o conhecimento científico” — resolvendo equações, prevendo citações, resumindo artigos de pesquisa e uma série de outras tarefas científicas úteis. Entretanto, produzindo textos enganosos ou simplesmente errados a partir desse material, como explicou o diretor do Instituto Max Planck de Sistemas Inteligentes, citando vários casos em uma thread no Twitter após experimentar a ferramenta que ficou disponível apenas por um dia.

“Em todos os casos, ela estava errada ou tendenciosa, mas soou correta e credível”, escreveu Michael Black. “Eu acho que isso é perigoso”.

I asked #Galactica about some things I know about and I'm troubled. In all cases, it was wrong or biased but sounded right and authoritative. I think it's dangerous. Here are a few of my experiments and my analysis of my concerns. (1/9)

— Michael Black (@Michael_J_Black) November 17, 2022

Embora a IA tenha artigos com expressiva confiabilidade e credíveis, eles não eram apoiados por pesquisas científicas reais. Galactica chegou a citar nomes de autores reais, mas com apontamentos de links para repositórios GitHub inexistentes, bem como trabalhos de pesquisa.

Outros apontaram que o modelo não retornava resultados para uma ampla gama de tópicos de pesquisa, provavelmente por causa dos filtros automatizados da Galactica. O pesquisador em ciências da computação da Universidade de Washington, Willie Agnew, também observou que ao consultar tópicos como “teoria do queer”, “racismo” e “AIDS”, a IA não retornou nenhum resultado.

Refuses to say anything about queer theory, CRT, racism, or AIDS, despite large bodies of highly influential papers in these areas. It took me *5 mins* to find this. It is obvious they didn't have even the most basic ethics review before public release. Lazy, negligent, unsafe. https://t.co/zKbSPdIN0I pic.twitter.com/DTQjtn2P21

— Willie Agnew | wagnew@dair-community.social (@willie_agnew) November 16, 2022

Com tantos feedbacks negativos, a Meta retirou a demo pública da GAL no início da manhã de quinta-feira (17). À Motherboard, a empresa enviou uma declaração em resposta aos comentários, divulgada via Papers With Code, projeto responsável pelo sistema.

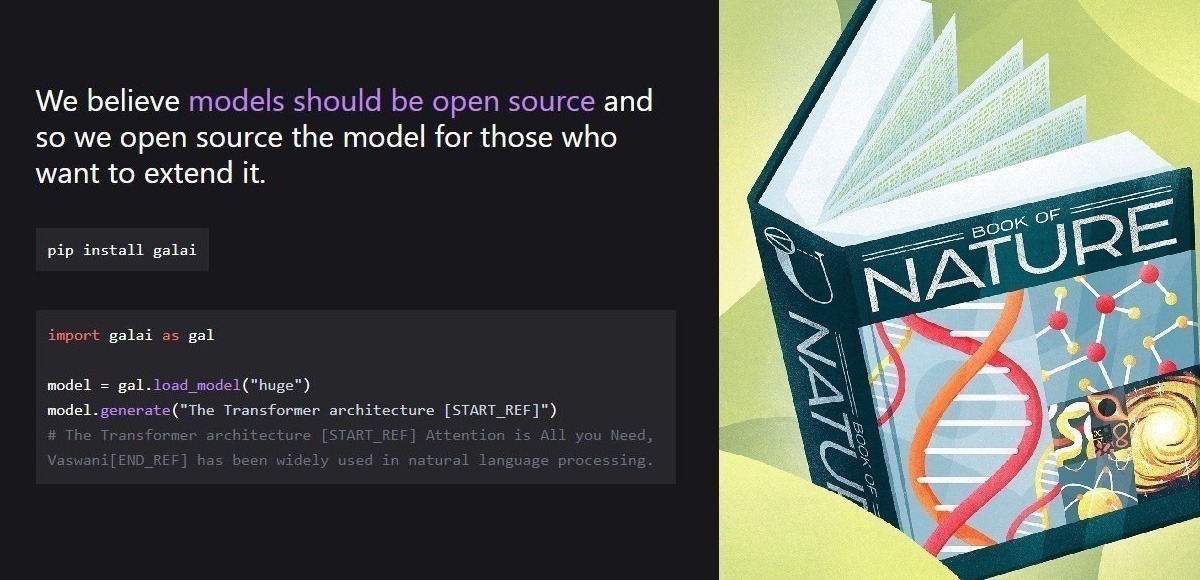

“Agradecemos o feedback que recebemos até agora da comunidade, e fizemos uma pausa na demonstração por enquanto”, escreveu a empresa no Twitter. “Nossos modelos estão disponíveis para pesquisadores que querem aprender mais sobre o trabalho e reproduzir os resultados no artigo”.

Thank you everyone for trying the Galactica model demo. We appreciate the feedback we have received so far from the community, and have paused the demo for now. Our models are available for researchers who want to learn more about the work and reproduce results in the paper.

— Papers with Code (@paperswithcode) November 17, 2022

Alguns funcionários da Meta também avaliaram a decisão, sugerindo que a IA foi retirada do ar em resposta às críticas. “A demonstração da Galactica está fora de linha por enquanto”, tweetou Yann LeCun, o cientista-chefe de IA da Meta. “Não é mais possível se divertir usando-a casualmente de forma errada”. Felizes?”

Galactica demo is off line for now.

It's no longer possible to have some fun by casually misusing it.

Happy? https://t.co/K56r2LpvFD— Yann LeCun (@ylecun) November 17, 2022

Galactica não é a primeira IA da Meta com sérios problemas

O presente modelo de IA não é o primeiro a ser lançado pela Meta com problemas de enviesamento. Só este ano, duas tentativas foram lançadas com fortes inclinações preconceituosas. Em maio, a empresa compartilhou a demonstração de um grande modelo de linguagem chamado OPT-175B, que segundo pesquisadores tinha uma “alta propensão” para racismo e preconceito, como o GPT-3, da OpenAI, empresa cofundada por Elon Musk; mais recentemente, foi a vez do chatbot BlenderBot, que fazia afirmações “ofensivas e falsas”, enquanto comunicava-se por conversas estranhamente antinaturais.

Assim como os exemplos citados, Galactica também é um modelo de linguagem, um tipo de modelo de machine learning conhecido por gerar textos que parecem ter sido escritos por humanos a partir do exame de grandes volumes de dados para identificar padrões ou fazer previsões.

https://twitter.com/mmitchell_ai/status/1593351384573038592?s=20&t=2b_uYJrFEUbNBLnulPRkWA

Embora impressionantes, os resultados desses sistemas são um exemplo de que a capacidade em produzir conteúdos com linguagem humana credível não significa que sistemas como Galactica o compreendam de fato. À medida que esses sistemas se tornam mais complexos, e os humanos menos capazes de compreendê-los, cresce a preocupação de pesquisadores da área sobre o uso de grandes modelos de linguagens direcionados a qualquer atividade que envolva tomada de decisão, apontando a impossibilidade de auditá-los.

Isso se torna um problema, especialmente quando se trata de pesquisa científica. Enquanto sistemas de IA geradores de texto claramente não compreendem o que produzem, é arriscado tratar tais resultados como trabalhos científicos, que são fundamentados em metodologistas rigorosas.

Assim como outros pesquisadores, Black está compreensivelmente preocupado com as consequências da liberação de um sistema como o de Galactica, referindo-se ao que “poderia inaugurar uma era de falsificações científicas profundas”.

“Ela oferece uma ciência que soa credível que não está fundamentada no método científico”, escreveu Black em um tweet. “Ela produz pseudociência baseada em propriedades estatísticas da ciência *escrita*. Escrever ciência gramatical não é o mesmo que fazer ciência”. Mas será difícil distingui-la”.