‘Humanos não conseguirão supervisionar de forma confiável sistemas de IA muito mais inteligentes do que nós’, diz cientista-chefe da OpenAI

Mesmo assim, líderes da equipe de alinhamento de superinteligência acham que ainda vale a pena tentar, mesmo que uso de IA para avaliação tenha potencial de aumentar inconsistências, vieses ou vulnerabilidades dessa IABy - Liliane Nakagawa, 7 julho 2023 às 21:23

A OpenAI está formando uma equipe que vai controlar futuras IAs superinteligentes, no entanto, para o cientista-chefe e cofundador da startup Ilya Sutskever, o grande problema seria a incapacidade de humanos supervisionarem algo muito mais inteligente que nós.

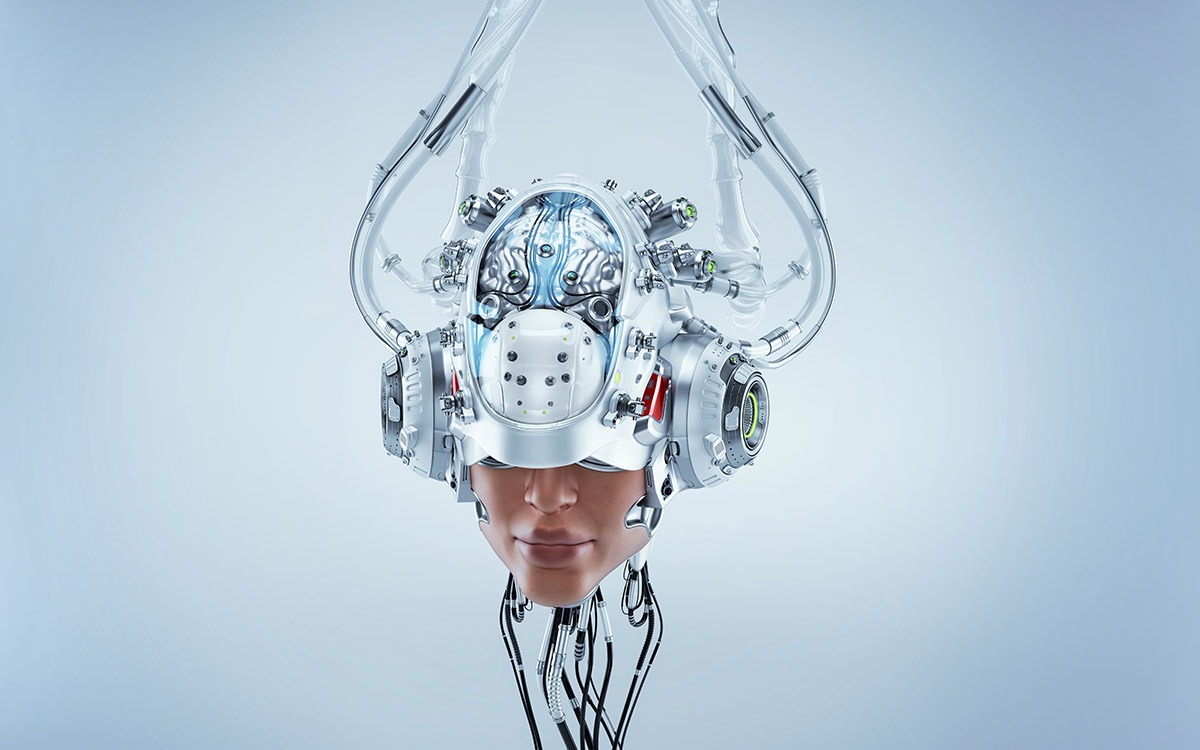

Imagem: Production/Shutterstock.com

De acordo com a previsão de Sutskever e Jan Leike, líderes da equipe de alinhamento de superinteligência da startup, a IA com inteligência superior à dos humanos deve chegar no fim desta década. E, se de fato ela venha a existir, eles afirmam que não será necessariamente benevolente, exigindo pesquisas sobre formas de controlá-la e restringi-la.

“Atualmente, não temos uma solução para dirigir ou controlar uma IA potencialmente superinteligente e evitar que ela se torne desonesta”, escrevem eles. “Nossas técnicas atuais para alinhar a IA, como o aprendizado por reforço a partir do feedback humano, dependem da capacidade dos humanos de supervisionar a IA. Mas os humanos não conseguirão supervisionar de forma confiável sistemas de IA muito mais inteligentes do que nós”, afirmaram em postagem no blog da OpenAI, publicada na quarta-feira (5).

Líderes de alinhamento de superinteligência da OpenAI reconhecem limitações, mas acham que vale a pena tentar, mesmo com graves problemas e incertezas

Caso a previsão de ambos seja fato dentro de 10 anos, a equipe de Superalinhamento, liderada pelos dois, vai tentar resolver os principais desafios técnicos de controle da IA superinteligente nos próximos quatro anos.

Nesse período, um “pesquisador de alinhamento automatizada de nível humano” vai treinar sistemas de IA usando feedback humano, treinar a IA para auxiliar na avaliação de outros sistemas de IA e criar uma IA que garanta que sistemas de IA alcancem os resultados desejados ou não saiam dos trilhos (responsável pela chamada “pesquisa de alinhamento”).

De acordo com a hipótese da OpenAI, a IA pode progredir em pesquisas de alinhamento mais rápido que os humanos. “À medida que progredirmos nisso, nossos sistemas de IA poderão assumir cada vez mais nosso trabalho de alinhamento e, por fim, conceber, implementar, estudar e desenvolver técnicas de alinhamento melhores do que as que temos agora”, postularam Leike e os colegas John Schulman e Jeffrey Wu em uma publicação anterior no blog.

“Eles trabalharão em conjunto com os humanos para garantir que seus próprios sucessores estejam mais alinhados com os humanos… Os pesquisadores humanos concentrarão cada vez mais seus esforços na revisão da pesquisa de alinhamento feita pelos sistemas de IA em vez de gerar essa pesquisa por conta própria”, acrescentaram.

Embora os três reconheçam limitações da OpenAI na publicação, Sutskever e Leike acham que ainda vale a pena tentar, mesmo que o uso de IA para avaliação tenha o potencial de aumentar inconsistências, os vieses ou as vulnerabilidades dessa IA, além da incerteza de que as partes mais difíceis do problema de alinhamento estejam relacionada à engenharia.

“O alinhamento da superinteligência é fundamentalmente um problema de aprendizado de máquina, e acreditamos que grandes especialistas em aprendizado de máquina — mesmo que ainda não estejam trabalhando no alinhamento — serão essenciais para resolvê-lo”, escreveram eles. “Planejamos compartilhar amplamente os frutos desse esforço e consideramos a contribuição para o alinhamento e a segurança de modelos que não sejam da OpenAI como uma parte importante do nosso trabalho.”

A nova equipe de alinhamento terá acesso a 20% da computação da empresa, garantida pela OpenAI até o momento, e terá participação de cientistas e engenheiros da divisão de alinhamento anterior da OpenAI, além de pesquisadores de outras organizações da empresa.

Via TechCrunch

Comentários