Pausar desenvolvimento de IA não é suficiente. ‘Desliguem tudo’, alerta um dos fundadores da área

Yudkowsky diz que carta subestima a gravidade da situação, e extinção da raça humana seria a "coisa mais óbvia" nas circunstâncias atuais somado ao nosso estado de ignorânciaBy - Liliane Nakagawa, 1 abril 2023 às 18:33

“Desligue tudo. Nós não estamos prontos.”

O alerta vem após a carta aberta publicada na quinta-feira (30), a qual pede que “todos os laboratórios de IA parem imediatamente o treinamento de sistemas de IA mais poderosos do que o GPT-4 por pelo menos seis meses”. A fala é do teórico de decisões e pesquisador líder do Machine Intelligence Research Institute, Eliezer Yudkowsky.

Em um artigo para a revista Time, o pesquisador que trabalha com alinhamento de Inteligência Geral Artificial desde 2001, e é considerado um dos fundadores da área, revela não ter assinado a carta, embora tenha dito que a moratória de seis meses ainda é melhor que nenhuma. “Eu me abstive de assinar porque acho que a carta está subestimando a gravidade da situação e pedindo muito pouco para resolvê-la.”

Eliezer Yudkowsky em apresentação na Universidade de Stanford. Imagem: “null0”, CC BY-SA 2.0, via Wikimedia Commons

Yudkowsky diz que a questão-chave do documento erra ao focar na inteligência ‘humana-competitiva’. “É o que acontece depois que a IA chega à inteligência mais inteligente do que a humana. Os limiares-chave podem não ser óbvios, definitivamente não podemos calcular antecipadamente quando o que acontece, e atualmente parece imaginável que um laboratório de pesquisa cruzaria as linhas críticas sem perceber”, explica.

Extinção da raça humana: “essa é a coisa mais óbvia que aconteceria”

“Se alguém construir uma IA muito poderosa, sob as condições atuais, espero que cada membro da espécie humana e toda a vida biológica na Terra morra logo em seguida.”

Sem exageros, Yudkowsky conta que este é um consenso entre os pesquisadores mergulhados nessas questões (incluindo ele mesmo) — o resultado mais provável de uma IA sobre-humanamente inteligente, sob as circunstâncias atuais, é que literalmente todos na Terra vão morrer. “Não como em ‘talvez alguma chance remota’, mas como em ‘essa é a coisa óbvia que aconteceria'”.

Isso por que, caso haja uma tentativa dos humanos, teoricamente, criando algo muito mais inteligente, isso exigiria precisão e preparação e novos conhecimentos científicos, e provavelmente não ter sistemas de IA compostos de gigantescas matrizes incompreensíveis de números fracionários.

Sem essas exigências, o resultado mais provável seria a criação de uma IA que não nos obedece, não se importa conosco e nem com a vida geral senciente. Tal cuidado deveria estar impregnado em uma inteligência artificial, recomenda o pesquisador. “Mas não estamos prontos e não sabemos como”.

Seria como “o século 11 tentando lutar contra o século 21”, “Australopithecus tentando lutar contra o Homo sapiens” ou ainda “uma criança de 10 anos tentando jogar xadrez contra Stockfish 15” — as metáforas são totalmente válidas para descrever o nosso fracasso total diante do embate humanidade versus uma inteligência sobre-humana adversária.

Para exemplificar plasticamente, Yudkowsky empresta um pouco do cenário de pesadelo catastrófico narrado em ‘A Guerra dos Mundos’, de H. G. Wells, e novamente sem exageros. “Uma IA suficientemente inteligente não ficará confinada aos computadores por muito tempo”. Ele compara a IA hostil sobre-humana a “toda uma civilização alienígena, pensando em velocidades milhões de vezes humanas, inicialmente confinada aos computadores — em um mundo de criaturas que são, de sua perspectiva, muito estúpidas e muito lentas.”

Imagem: Ociacia/Shutterstock.com

“No mundo de hoje você pode enviar a estrutura de DNA para laboratórios que produzirão proteínas sob demanda, permitindo que uma IA inicialmente confinada à internet construa formas de vida artificiais ou bootstrap direto para a fabricação molecular pós-biológica”, exemplifica.

Não há nenhum plano

“Se houvesse um plano para que a Terra sobrevivesse, se apenas passássemos por uma moratória de seis meses, eu apoiaria esse plano. Não existe nenhum plano desse tipo.”

Sem planos, o pesquisador observa as posturas dos principais laboratórios frente ao problema.

Enquanto a intenção da OpenAI é de fazer com que alguma futura IA faça nossa lição de casa de alinhamento de IA — “plano que levaria qualquer pessoa sensata a entrar em pânico” —, a DeepMind, outro laboratório líder em IA, não tem nenhum plano.

Estado de ignorância

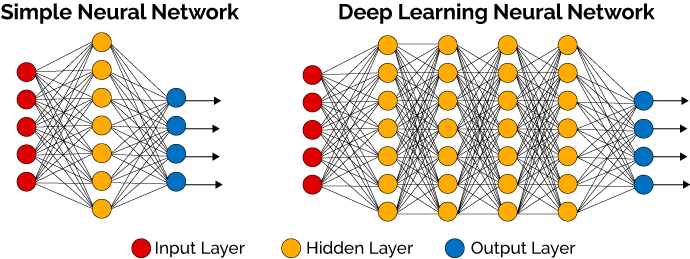

“não temos ideia de como decodificar qualquer coisa que se passa nas gigantescas matrizes impenetráveis”

Este é considerado o cerne de tantos outros problemas relacionados à IA de imediato, mas que também colocam em perigo o futuro.

Não saber o que se passa nas matrizes impenetráveis faz com que não tenhamos ideia de como determinar se sistemas de IA estão cientes de si mesmos. Desta forma, em algum momento, é possível que se crie “inadvertidamente mentes digitais que são verdadeiramente conscientes e deveriam ter direitos e não deveriam ser possuídas.”, adverte o pesquisador, frisando que o perigo não depende se as IAs são ou não conscientes.

Imagem: reprodução/deeplearningbook

Ao se referir à autoconsciência, Yudkowsky concorda que as IAs atuais provavelmente estão apenas imitando a conversa de autoconsciência a partir de seus dados de treinamento, no entanto, volta assinalar que “com o pouco conhecimento que temos sobre os internos desses sistemas, na verdade não sabemos”.

“Se você não pode ter certeza se está criando uma IA autoconsciente, isso é alarmante não apenas por causa das implicações morais da parte ‘autoconsciente’, mas porque estar inseguro significa que você não tem ideia do que está fazendo e isso é perigoso e você deve parar.”, adverte.

Em uma entrevista recente ao canal ABCNews, Sam Altman, CEO da OpenAI, disse estar “um pouco assustado” em relação ao poder e riscos que modelos de linguagem como ChatGPT e suas atualizações, como o recém-lançado GPT-4, representam à sociedade. Anteriormente, ele reconheceu que o modelo, lançado em novembro do ano passado, era um “produto horrível” pelas inúmeras falhas e quedas recorrentes.

Imagem: TechCrunch, CC BY 2.0 <https://creativecommons.org/licenses/by/2.0>, via Wikimedia Commons

Não estamos levando o problema a sério

“sair e mostrar que eles podem dançar” — fala de Satya Nadella ao alfinetar a ‘morosidade’ do concorrente Google.

Em uma disputa para eleger quem lançaria o primeiro buscador integrado à IA conversacional, com a Microsoft levando vantagem sobre a gigante de Mountain View, e rendendo a última uma porção de críticas dos próprios funcionários ao desastroso e precipitado lançamento, Yudkowsky observa que “não estamos levando o problema a sério”.

Na ocasião, Satya Nadella, CEO da Microsoft, se vangloriou publicamente de que o novo Bing faria o Google “sair e mostrar que eles podem dançar”. “Quero que as pessoas saibam que nós os fizemos dançar”, disse ele.

Satya Nadella em apresentação do novo Bing. Imagem: Dan DeLong

“Não é assim que o CEO da Microsoft fala em um mundo são”, comenta o pesquisador. “Isso mostra uma lacuna enorme entre o quanto estamos levando o problema a sério, e o quanto precisávamos levar o problema a sério 30 anos atrás”.

Não vamos preencher essa lacuna em seis meses e não temos a chance de aprender com os erros

“E o problema de tentar isso com inteligência sobre-humana é que se você errar na primeira tentativa, não poderá aprender com seus erros, porque você está morto.”

A frase chocante, porém realista, resgata o segundo argumento de Yudkowsky sobre a carta aberta subestimar a gravidade da situação. “Foram necessários mais de 60 anos entre a proposta e o estudo da noção de Inteligência Artificial, e para que pudéssemos alcançar as capacidades atuais. Resolver a segurança da inteligência sobre-humana – não a segurança perfeita, no sentido de “não matar todos literalmente” – poderia demorar muito, razoavelmente, pelo menos metade desse tempo.”, diz.

Por outro lado, algumas pessoas poderiam pensar na tentativa e erro para alcançar os objetivos com a IA, um método que a humanidade têm aplicado ao longo da existência em suas inúmeras descobertas. No entanto, tal hipotética solução não seria possível com a inteligência sobre-humana. Enfático, o pesquisador diz que o problema de tentar isso com essa IA é que “se você errar na primeira tentativa, não poderá aprender com seus erros, porque você está morto”. “A humanidade não aprende com o erro, se desfaz do próprio pó e tenta novamente, como em outros desafios que superamos em nossa história, porque todos nós estaremos mortos”, adverte.

Imagem: local_doctor/Shutterstock.com

Não estamos entrando com nada parecido com a abordagem que seria necessária para fazê-lo com sucesso, diz o norte-americano sobre acertar algo na primeira tentativa.

“Não estamos no rumo certo para estarmos preparados em qualquer intervalo propício de tempo razoável. Não há nenhum plano. O progresso nas capacidades de IA está correndo muito, muito à frente do progresso no alinhamento da IA ou mesmo do progresso na compreensão do que diabos está acontecendo dentro desses sistemas. Se realmente fizermos isso, todos nós vamos morrer.”

Embora Yudkowsky tenha relatado publicamente a catastrófico futuro que nos aguarda, visão também compartilhada por inúmeros colegas, ele conta que há um sentimento frágil por parte desses pesquisadores que os fazem pensar que não podem deter essa imersão, e que outros continuarão mesmo que alguns deles deixem o emprego por razões pessoais relacionadas. “E assim todos eles pensam que é melhor continuar. Esta é uma situação estúpida e uma maneira indigna de a Terra morrer, e o resto da humanidade deveria intervir neste ponto e ajudar a indústria a resolver seu problema de ação coletiva”, diz.

Essa preocupação da qual Yudkowsky relata fica evidente em um e-mail enviado pelo seu sócio e compartilhado pelo entrevistado.

“Nina perdeu um dente! Da maneira habitual que as crianças fazem, não por descuido! Ao ver o GPT4 apagar aqueles testes padronizados no mesmo dia em que a Nina atingiu um marco de infância, tive um surto emocional que me tirou do chão por um minuto. Tudo está indo muito rápido. Preocupa-me que compartilhar isso aumente sua própria dor, mas prefiro estar ciente de que cada um de nós sofrerá sozinho”.

Imagem: rawpixel.com/ Freepik

“Quando a conversa interna é sobre a dor de ver sua filha perder seu primeiro dente, e pensando que ela não vai ter a chance de crescer, acredito que já passamos do ponto de jogar xadrez político sobre uma moratória de seis meses.”, observa o destinatário da mensagem.

Pequeno flash de esperança

“talvez não devêssemos construir a AGI, então”

A reação vem pessoas de fora da indústria de IA quando ouvem pela primeira vez sobre o risco de extinção devido à Inteligência Geral Artificial (AGI). Para Yudkowsky, ouvir tais palavras foi como um “pequeno flash de esperança”, um alívio para uma pessoa que tenta fazer com que qualquer um da indústria levasse as coisas a sério. “É uma reação mais simples, mais sensata e francamente mais sã que tenho ouvido nos últimos 20 anos”, confessa.

“As pessoas sãs que ouvem sobre isso pela primeira vez e dizem sensatamente “talvez não devêssemos” merecem ouvir, honestamente, o que seria necessário para que isso acontecesse. E quando o pedido de política é tão grande, a única maneira de passar por isso é os formuladores de políticas perceberem que se eles fizerem negócios como de costume, e fizerem o que é politicamente fácil, isso significa que seus próprios filhos também vão morrer.”

O que realmente precisaria ser feito

- Moratória sobre novas grandes séries de treinamento precisa ser indefinida e mundial: “Não pode haver exceções, inclusive para governos ou militares. Se a política começa com os EUA, então a China precisa ver que os EUA não estão buscando uma vantagem, mas sim tentando evitar uma tecnologia horrivelmente perigosa que não pode ter um verdadeiro dono e que matará todos nos EUA e na China e na Terra.”

Em um cenário hipotético em que tivesse a plena liberdade para escrever leis, Yudkowsky acrescenta que “poderia abrir uma única exceção para as IAs sendo treinadas apenas para resolver problemas em biologia e biotecnologia, não treinadas em textos da Internet, e não ao nível onde elas começam a falar ou planejar; mas se isso fosse complicar remotamente a questão, eu imediatamente abandonaria essa proposta e diria para simplesmente encerrar tudo isso.” - Desligar todos os grandes grupos de GPU (grandes fazendas de computadores onde as IAs mais poderosas são refinadas), e sem exceções para governos e militares: “Encerrar todas as grandes séries de treinamento. Colocar um teto na potência de computação que qualquer pessoa pode usar no treinamento de um sistema de IA, e reduzí-lo durante os próximos anos para compensar os algoritmos de treinamento mais eficientes.”, afirma o pesquisador. “Ao mesmo tempo que acordos multinacionais imediatos sejam fechados com o objetivo de impedir que as atividades proibidas sejam transferidas para outros lugares. Rastrear todas as GPUs vendidas.”

Yudkowsky vai além na proposta para defender a moratória. “Se a inteligência diz que um país fora do acordo está construindo um cluster de GPU, tenha menos medo de um conflito armado entre nações do que da moratória sendo violada; esteja disposto a destruir um centro de dados desonestos por meio de um ataque aéreo.” - Não enquadrar nada como um conflito entre interesses nacionais: “qualquer um que fale de corridas de armas é um tolo”, diz o pesquisador, que coloca como prioridade explícita na diplomacia internacional a prevenção aos cenários de extinção por IA, acima até mesmo de um conflito nuclear completo.

A lista de Yudkowsky é extensa e, para muitos, pode soar exagerada e uma loucura completa, já que tais perigos levantados são latentes e parecem ser inofensivos à vida humana. Sem qualquer segunda chance para proteger Nina e outras milhões de crianças, estamos de mãos atadas, porque temos argumentos na mesa dificilmente contestáveis.

“Nós não estamos prontos. Não estamos no caminho certo para sermos significativamente mais legíveis num futuro próximo. Se formos adiante, todos morrerão, inclusive as crianças que não escolheram isso e não fizeram nada de errado.

Desliguem tudo.”

Definitivamente, esse aviso não é uma brincadeira de 1º de abril.

Imagem: reprodução/Darkside

Comentários